Récap du T3CON - L'IA démystifiée : Meilleures pratiques durables et intelligentes pour l'intelligence artificielle

Auteurs : Mathias Bolt Lesniak

Traduit par : Léo - W-Seils

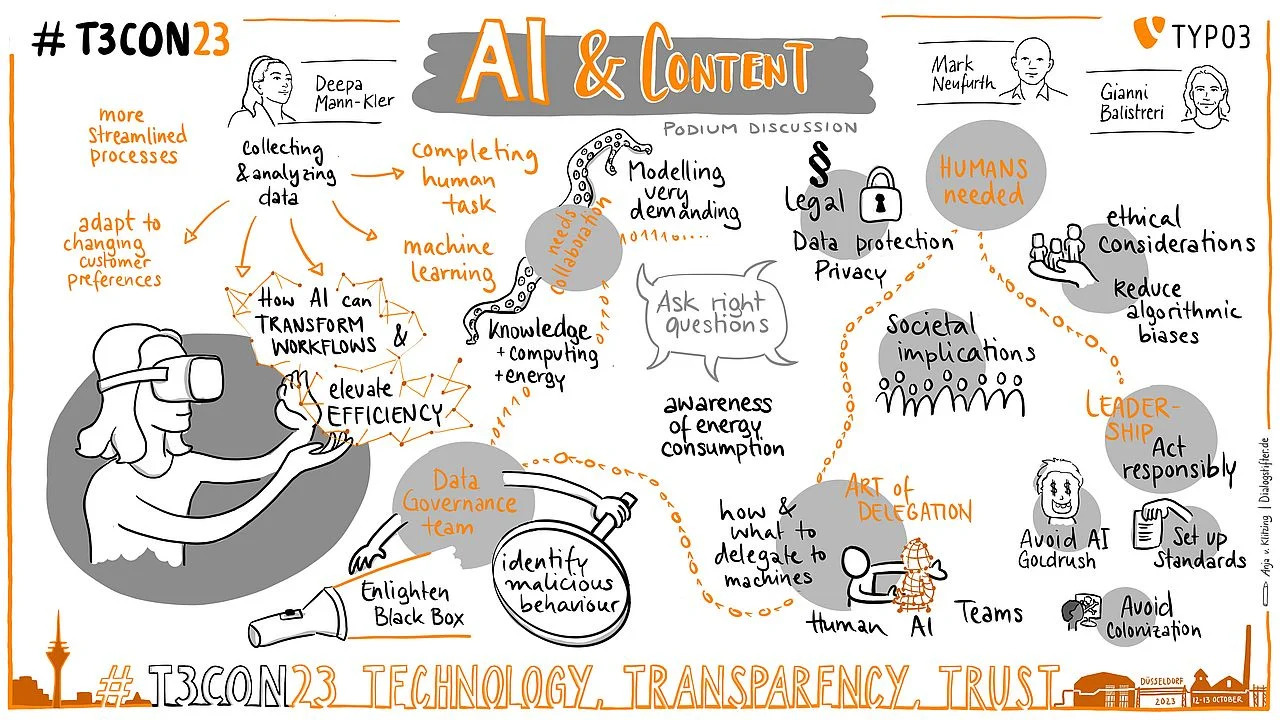

L'intelligence artificielle est-elle une fatalité ou la porte d'un avenir idéal ? Et comment avons-nous le temps de faire les bons choix lorsque l'innovation se produit à une vitesse fulgurante ? Lors de la conférence T3CON23, Deepa Mann-Kler, leader d'opinion, Mark Neufurth, expert en hébergement, et Gianni Balistreri, ingénieur en IA, ont discuté de l'immense potentiel et des grands défis auxquels nous sommes confrontés avec cette technologie qui évolue rapidement.

La conversation a permis de dissiper des idées fausses, de découvrir des faits gênants et d'illustrer les meilleures pratiques. Reconnaître le facteur humain et l'importance de la bonne gouvernance, de l'ouverture et de la collaboration pourrait être la clé d'une utilisation intelligente et durable de l'IA.

Lisez la suite pour un récapitulatif complet de cette discussion de podium, ou rattrapez ce que vous avez manqué à T3CON23 et préparez-vous pour T3CON24.

À propos des intervenants

Conférencière TEDx et leader d'opinion, Deepa Mann-Kler est PDG de Neon, une entreprise britannique qui exploite la puissance des technologies immersives pour créer des expériences narratives authentiques en réalité augmentée et virtuelle.

Fort de 25 ans d'expérience sur le marché de l'hébergement web et de l'informatique en nuage, Mark Neufurth est le principal stratège du fournisseur d'hébergement IONOS. Il travaille depuis longtemps avec le prédécesseur de l'entreprise, 1&1, et a participé à l'analyse du marché, à la stratégie commerciale et à la préparation de fusions et d'acquisitions.

Gianni Balistreri est un data scientist et un ingénieur en IA passionné depuis 2015. Il est responsable de l'apprentissage automatique pour la société de commerce électronique open-source Shopware, où il est chargé de développer des fonctionnalités basées sur l'IA.

L'IA pour les tâches répétitives, complexes et routinières

Deepa Mann-Kler a commencé par démystifier l'IA et mettre en évidence certains de ses effets positifs potentiels. Elle a entamé la conversation en expliquant comment l'IA a changé la donne en matière de collecte et d'analyse des données. "Les données sont au cœur de l'IA", a-t-elle déclaré. "Plus les données sur lesquelles l'IA est entraînée sont complètes, plus le résultat est précieux. Cependant, l'idée même de données n'est pas nouvelle, a-t-elle expliqué : "L'os d'Ishango est considéré comme l'une des premières preuves de stockage de données préhistoriques. Les hommes du paléolithique utilisaient des bâtons de pointage pour enregistrer les activités commerciales et suivre les réserves de nourriture.

"Nous utilisons déjà l'IA tous les jours", poursuit M. Mann-Kler. "Même si nous ne nous rendons pas toujours compte que les entreprises de nombreux secteurs l'utilisent pour affiner les flux de travail et améliorer l'efficacité." Elle a donné cinq exemples illustrant ce fait :

- "Amazon utilise l'IA dans ses entrepôts pour optimiser la logistique. La robotique, alimentée par l'IA, aide à trier, emballer et expédier les colis, ce qui rend l'ensemble de la chaîne d'approvisionnement plus efficace. [Les scientifiques d'Amazon Technologies à Berlin utilisent l'IA pour signaler les produits défectueux avant qu'ils ne soient expédiés. [...] Chaque article qui passe par leur entrepôt est scanné, et ce système est trois fois plus efficace que l'identification manuelle des produits endommagés."

- "Adobe Sensei utilise l'IA pour l'expérience client et la créativité. Il est utilisé par les analystes, les spécialistes du marketing, les créatifs et les publicitaires pour rationaliser les flux de travail de bout en bout, des idées à la production. En ce qui concerne la découverte et la manipulation d'images, Sensei reconnaît les images dans la bibliothèque multimédia d'Adobe Creative Cloud. Il suggère ensuite des balises qui identifient des éléments dans les images, tels que des visages ou des bâtiments, ce qui facilite la catégorisation et la recherche."

- "Uber utilise l'IA pour détecter les fraudes, identifier les risques, mettre en relation les usagers et les chauffeurs, suivre et optimiser les itinéraires, la tarification dynamique, la prévision de la demande, la localisation des utilisateurs, les schémas de circulation et les informations historiques sur les trajets."

- "Siemens utilise l'IA dans la fabrication pour la maintenance prédictive. En analysant les données des capteurs de ses machines, l'entreprise peut prédire quand l'équipement est susceptible de tomber en panne, ce qui permet une maintenance proactive et réduit les temps d'arrêt."

- "Netflix investit massivement dans l'apprentissage automatique et utilise l'historique de visionnage, les préférences et les évaluations pour suggérer des films et des émissions de télévision. L'entreprise est présente dans plus de 190 pays et utilise la traduction et la localisation par IA pour traduire le contenu dans plusieurs langues, y compris les sous-titres et les voix off."

Deepa Mann-Kler a ouvert la session avec un aperçu des meilleures pratiques actuelles en matière d'IA. (Copyright : Markus Luigs)

M. Mann-Kler a également précisé que l'IA ne signifie pas qu'aucun humain n'est impliqué : "Ces modèles sont utiles, mais il arrive qu'ils soient trompés. Prenant l'exemple d'Amazon, elle a expliqué que les personnes qui agissent en tant qu'experts en dommages "enseignent directement à l'IA comment prendre de meilleures décisions à l'avenir". C'est cette collaboration entre les humains et les machines qui permet d'obtenir de bien meilleurs résultats pour nos clients.

M. Mann-Kler conclut que l'IA est la meilleure solution pour accomplir des tâches humaines répétitives, complexes et routinières. "Elle permet aux humains de se concentrer sur la créativité et la stratégie.

M. Mann-Kler a souligné que tout ne peut pas ou ne doit pas être automatisé par l'IA : "Certains flux de travail nécessitent un jugement humain, de la créativité ou de l'empathie. D'autres impliquent des données sensibles ou confidentielles qui doivent être protégées. Enfin, certains flux de travail ont des implications éthiques ou juridiques".

Selon M. Mann-Kler, nous devons veiller à éviter la ruée vers l'or de l'IA, qui doit être mise en œuvre de manière responsable en tenant compte des considérations éthiques, de la confidentialité des données et des préjugés potentiels. La technologie doit utiliser des algorithmes qui garantissent son équilibre et sa durabilité.

Encore une fois, l'intelligence artificielle ne peut fonctionner sans les humains. Elle a expliqué que "la mise en œuvre de l'IA implique une combinaison de pratiques conscientes et réfléchies, de considérations éthiques et d'une vigilance permanente". Les cadres doivent être construits de manière à donner la priorité à l'équité, à la transparence et à la responsabilité, ainsi qu'aux normes :

"Les normes et les lignes directrices de l'industrie sont essentielles au développement et au déploiement de l'IA. Les modèles d'IA doivent être formés de manière éthique sur des ensembles de données diversifiés et représentatifs afin de réduire les biais."

- Deepa Mann-Kler, Neon

Quatre défis au succès de l'IA

Plus tard dans la session, Mark Neufurth a apporté une autre dimension à la discussion sur la ruée vers l'or de l'IA. Il a expliqué que l'IA est en effet un véritable facteur de changement, mais qu'il est nécessaire de se demander "comment la rendre réalisable, comment la rendre abordable et comment la rendre utilisable pour nos clients".

En se plaçant du point de vue des clients, M. Neufurth a énuméré quatre défis à relever pour assurer le succès de l'IA :

- La connaissance. "Comprenez-vous ce que signifie cette modélisation ? [L'IA et l'apprentissage automatique sont réservés aux personnes instruites et aux adultes", a-t-il fait remarquer, avant d'expliquer qu'il s'agit d'une élite. Peu de personnes possèdent les connaissances nécessaires pour travailler avec l'IA. "Il faut des mathématiques. Il faut des statistiques. Il faut des connaissances approfondies dans ces deux domaines. [...] Il n'y a que quelques personnes capables de travailler sur la modélisation de l'IA. [...] On ne peut donc pas passer à l'échelle supérieure."

- L'argent. M. Neufurth a raconté que l'apprentissage automatique existait depuis une dizaine d'années lorsque OpenAI et GPT sont apparus. "Microsoft a spéculé et investi massivement dans cet outil. C'était un pari sur l'avenir. Mais nous [les autres] n'avons pas l'argent nécessaire pour parier sur l'avenir".

- Propriété. Un client ou une entreprise n'aura pas les compétences nécessaires pour construire ses propres modèles de fondation, "il y a des aspects juridiques, des aspects de souveraineté, bien sûr, et des aspects de durabilité. Enfin, il y a les aspects économiques", a déclaré M. Neufurth. "Nous misons beaucoup sur les modèles open source parce que nous ne voulons pas devenir dépendants d'un ou deux fournisseurs oligopolistiques sur le marché des États-Unis ou de la Chine.

- Complexité. Le dernier point soulevé par M. Neufurth est que les clients auront des besoins différents. Certains "ne veulent pas s'occuper de l'IA au quotidien", tandis que d'autres ont besoin de services d'hébergement pour des solutions d'IA "construites par les clients eux-mêmes".

Nécessité d'une détection des préjugés en temps réel

Une IA équilibrée et durable ne consiste pas seulement à être un être humain conscient et éthique. Il faut aussi se demander qui a créé le modèle d'IA. Deepa Mann-Kler a cité la fondatrice de Women in AI, Moojan Asghari: "L'intelligence artificielle reflétera les valeurs de ses créateurs. L'IA utilise les données que son créateur lui fournit et transmet les préjugés de ce dernier.

Elle explique que c'est "la raison pour laquelle nous ne pouvons pas laisser ce travail aux seuls technologues, qui sont pour la plupart des hommes. Nous devons éliminer les préjugés des algorithmes [...]. Ces outils doivent détecter et atténuer les préjugés en temps réel."

Cela a également été démontré par les recherches de Joy Buolamwini, fondatrice de l'Algorithmic Justice League, que Mann-Kler a soulignées : "Même si l'IA peut automatiser de nombreuses tâches. Le jugement humain est crucial dans les domaines des implications éthiques, juridiques ou sociétales. Les jugements s'accompagnent de responsabilités et la responsabilité incombe aux humains en fin de compte."

"Nous misons beaucoup sur les modèles open source parce que nous ne voulons pas devenir dépendants d'un ou deux fournisseurs oligopolistiques sur le marché des États-Unis ou de la Chine."

- Mark Neufurth, IONOS

Mesures d'urgence en cas de défaillance inattendue de l'IA

"Comment savons-nous que nous faisons les choses correctement ? a demandé M. Mann-Kler, de manière rhétorique. "En menant des audits réguliers pour identifier et rectifier les problèmes, et en mettant en œuvre des mécanismes de contrôle et d'évaluation continus pour garantir l'alignement sur les normes éthiques et les exigences réglementaires. Cela doit impliquer les parties prenantes internes et externes, les employés, les clients et les communautés concernées dans les processus de développement de l'IA."

Cela signifie que les modèles d'IA doivent pouvoir être expliqués, ce qui permettrait de recueillir des commentaires, de communiquer de manière transparente et de répondre aux préoccupations concernant l'utilisation prévue et l'impact des technologies d'IA.

Mme Mann-Kler s'est également inquiétée du fait que les cadres législatifs ne protégeront jamais parfaitement et qu'un dysfonctionnement technologique est toujours possible : "Alors que les législateurs et la législation sont toujours en train de rattraper la technologie, et que les frontières nationales ne s'appliquent plus, nous devons toujours adhérer aux réglementations et aux cadres juridiques pertinents. Les systèmes d'IA doivent se conformer aux normes relatives à la protection des données, à la vie privée et à d'autres exigences spécifiques à l'industrie. Nous devons anticiper et élaborer des plans de redondance et d'urgence en cas de défaillance inattendue de l'IA."

Un appel à des politiques responsables en matière d'intelligence artificielle

Mme Mann-Kler a clairement indiqué que l'intelligence artificielle nécessitait un effort collectif. "Nous devons encourager l'ouverture et la collaboration en partageant les idées, les meilleures pratiques et les leçons apprises, afin de relever collectivement les défis et de favoriser une culture de développement responsable de l'IA."

Selon M. Mann-Kler, une politique responsable en matière d'IA devrait :

- S'aligner sur les valeurs, la mission, les principes et les objectifs de l'organisation.

- Établir des procédures de contrôle pour examiner et approuver les systèmes d'IA avant leur déploiement.

- Détailler lesprotocoles decollecte, de stockage, d'utilisation et de suppression des données.

- Inclure des considérations relatives au consentement, à la vie privée, à la sécurité et aux biais des données.

Gianni Balistreri a ajouté des perspectives sur la façon dont Shopware relève les défis de l'éthique et de la conformité en relation avec leur logiciel de commerce électronique.

"Les scientifiques et les ingénieurs des données ne construisent pas seulement des boîtes noires qu'ils sont les seuls à pouvoir comprendre. Souvent, même eux ne peuvent pas les comprendre, parce qu'elles sont tellement complexes".

- Gianni Balistreri, Shopware

Pour résoudre ce problème, Gianni a mis en œuvre trois mesures :

"Tout d'abord, une équipe de gouvernance des données. Nous pouvons ainsi surveiller ce que fait le système d'IA et les résultats obtenus, et prévenir les comportements malveillants. La deuxième chose est d'"éclairer la boîte noire", pour ainsi dire. [Vous pouvez prendre plusieurs mesures pour comprendre pourquoi ce système d'IA fait ce qu'il fait. Et si vous pouvez le comprendre, et si quelque chose ne va pas, vous pouvez intervenir. Troisièmement, nous disposons d'une liste complète de politiques pour améliorer la sécurité et nous assurer que les données que nous possédons sont stockées en toute sécurité. [...] Il est donc important pour nous de veiller à ce qu'elles soient anonymes. Et même si les pirates s'introduisent dans notre système, ils ne peuvent pas utiliser les données parce qu'ils ne peuvent pas les relier à d'autres personnes."

Impact négatif de l'IA sur la société et l'environnement

Mme Mann-Kler a ensuite évoqué les effets sociétaux potentiellement désastreux de l'IA, à la fois lorsqu'elle déforme et amplifie les préjugés, et lorsqu'elle est testée sur des personnes qui n'ont pas la possibilité de se retirer, concluant que "nous avons tous une responsabilité dans la manière dont nous partageons nos visions futures de l'IA".

"Timnit Gebru, directrice de l'Institut de recherche sur l'IA distribuée, explique que les chercheurs, dont de nombreuses femmes de couleur, disent depuis des années que ces systèmes interagissent différemment avec les personnes de couleur", explique Mme Mann-Kler. "Ses collègues ont également exprimé leur inquiétude quant à l'exploitation des travailleurs fortement surveillés et faiblement rémunérés qui ont contribué à soutenir les systèmes d'IA par le biais du contenu, de la modération et des annotateurs de données. Ils sont souvent issus de communautés pauvres et mal desservies, comme les réfugiés et les populations carcérales. Au Kenya, des modérateurs de contenu ont subi de graves traumatismes, de l'anxiété et des dépressions après avoir regardé des vidéos d'abus sexuels sur des enfants, de meurtres, de viols et de suicides afin de former ChatGPT sur ce qui constitue un contenu explicite ; ils étaient payés moins de 1,25 € de l'heure.

Certains des effets positifs de l'IA ont également des effets secondaires négatifs. Microsoft a augmenté sa consommation mondiale d'eau de 34 % (1,7 milliard de gallons ou 6,4 milliards de litres) en 2022, en raison de l'augmentation de la formation à l'IA. Au cours de la même période, Google a utilisé 5,6 milliards de gallons (21,2 milliards de litres) d'eau, une augmentation de 20 % également attribuable à l'apprentissage automatique. En 2023, les centres de données d'IA ont aggravé la sécheresse dans l'Iowa.

"Je me demanderais, même si je travaille dans cet espace, s'il existe une meilleure façon de faire ce que je faisais jusqu'à présent. Qui n'a pas voix au chapitre ? Qui puis-je inclure ? Qu'est-ce que je ne sais pas ?

Deepa Mann-Kler, Neon

Analyser l'horizon de l'IA, tirer les leçons des erreurs du passé

Les trois panélistes ont commenté les différences de réaction face à l'IA. M. Balisteri a souligné que l'approche de l'IA diffère d'un pays à l'autre et d'un continent à l'autre : "À mon avis, surtout en Allemagne et en Europe, nous avons peur de cette technologie. [D'autres pays, comme les États-Unis, le Canada, Israël et la Chine, ont une autre mentalité. Avec ces nouvelles technologies qui évoluent rapidement, il faut avoir la mentalité de faire des expériences et de voir ce qui se passe".

Pour Mark Neufurth, cette différence peut être à la fois bonne et mauvaise : "En Europe, nous sommes plutôt passifs, nous regardons les choses de manière plutôt hésitante. [...] C'est une bonne chose [...] car nous y réfléchissons à deux fois. D'un autre côté, en termes d'économies de plateforme, une plateforme établie pourrait se développer, qui dominerait tout et avec laquelle personne ne pourrait plus interférer".

Deepa Mann-Kler a déclaré que nous devrions tirer les leçons des erreurs du passé.

"Je me demanderais, même si je travaille dans cet espace, s'il existe une meilleure façon de faire ce que j'ai fait. Quelle voix n'est pas présente dans la pièce ? Qui puis-je inclure ? Qu'est-ce que je ne sais pas ? Je ferais une pause pour réfléchir à l'IA. Dans le contexte de tout ce qu'elle touche - analyse de l'horizon - quelles sont les implications potentielles ? Quelles sont les conséquences involontaires potentielles ? Quels sont les risques ?

L'avenir n'est pas prédéterminé, qu'il soit dystopique ou idéal.

Deepa Mann-Kler a conclu en commentant la tendance à fournir un "récit dystopique extrême de l'avenir où l'IA détruit l'espèce humaine".

Elle a cité l'expert en vision lointaine Alex Fergnani, qui écrit que "les intellectuels publics devraient discuter de manière impartiale des multiples images de l'avenir pour enseigner au public que l'avenir n'est pas prédéterminé. Ils doivent également examiner méticuleusement les visions de l'avenir qu'ils présentent, en tenant compte de la charge émotionnelle qu'elles véhiculent, afin d'éviter l'alarmisme ou l'idéalisation excessive. En outre, il est essentiel qu'ils veillent à ce que ces visions ne soient pas influencées par des tendances fugaces et des événements immédiats".

M. Mann-Kler poursuit : "Lorsque l'imprimerie a été inventée, les gens ont eu peur que nous perdions la mémoire. Lorsque les bicyclettes ont été inventées, les gens ont craint qu'elles n'encouragent la promiscuité sexuelle. Et lorsque les trains à vapeur ont été inventés, les gens craignaient qu'ils aillent si vite que nous nous cassions tous les os.

L'élaboration d'une bonne solution prend du temps. "Nous devrions tous avoir notre mot à dire sur les technologies qui sont fabriquées, sur ceux qui les fabriquent et sur la manière dont elles sont utilisées.

N'oubliez pas de vous inscrire à T3CON24 pour assister à d'autres conférences étonnantes comme celle-ci.